小米大模型第二代来了!

相比第一代,训练数据规模更大、品质更高,训练策略与微调机制上也进行了深入打磨。

不仅窗口长度增长到了原来的50倍,在10大能力维度上表现相比于第一代平均提升超过45%。

而且家族成员丰富,有从0.3B到30B多个参数规模,分别适配云边端各侧设备。

此外,第二代大语言模型在端侧部署上还支持3种推理加速方案,包括大小模型投机、BiTA、Medusa,相比于业界标准高通方案,量化损失降低78%。

大模型架构基础研究

针对预训练、后训练、量化、推理加速等大模型具体研发方向,小米团队做了大量研究,并将部分成果以论文的形式发布出来。

今年以来,小米大模型团队发表了11篇论文(5篇ACL、3篇EMNLP、1篇NIPS、1篇ECAI、1篇COLING),申请了30+项发明专利,其中部分代表性的工作如下:

SUBLLM

项目主页:https://github.com/XiaoMi/subllm

SUBLLM基于Transformer结构,创新性地提出了一种新的模型结构。

其中设计了Subsampling、Upsampling和Bypass等新模块,使得模型能够区分重要token和不重要token。

针对重要tokens花更多的算力学习,保持few shot能力不变的同时,训练和推理速度分别提升34%和52%。

该研究对标Google Deepmind的mixture of depths工作,兼容现有attention based大模型生态。

TransAct

论文地址:https://arxiv.org/abs/2407.05690

TransAct是一种大模型结构化剪枝方法。

为了在大模型上同时实现高度压缩和较小损失,小米大模型团队设计了TransAct。

本方法以减小Transformer模块内隐藏表征维度为目标,以各神经元的激活值大小为依据,剪除激活值较小的神经元,形成类低秩表示的模块结构,同时保留 LayerNorm 等对扰动敏感的模块间隐藏表征维度。

对比之前业界最佳的剪枝方法,TransAct方法剪枝模型的KV Cache下降了50%,推理速度提升了20%(小米14手机测试)。

INTRADoc

论文地址:https://arxiv.org/abs/2402.13991

INTRADoc是一种新的注意力机制。

它通过屏蔽无关文档,让每个token的概率仅取决于同一文档中的上文信息,进而消除了来自之前无关文档的潜在干扰信息。

结果,INTRADoc显著地提高了模型上下文学习、知识记忆、上下文利用能力。

Mixture of Diverse Size Experts

论文地址:https://arxiv.org/abs/2409.12210

这是一种新的MoE结构,简称为MoDSE。

它在每一层中设计大小不同的专家结构,并同时引入了一种专家对分配策略,以在多个GPU之间均匀分配工作负载。

在多个基准测试中,MoDSE通过自适应地将参数预算分配给专家,在保持总参数量和专家个数相同的情况下,表现优于传统MoE结构。

性能平均提升45%

小米第二代模型MiLM2系列融合多项前沿技术模型效果全面超越了第一代。

小米大模型团队采用自主构建的通用能力评测集Mi-LLMBM2.0,对最新一代的MiLM2模型进行了全方位评估。

该评测集涵盖了广泛的应用场景,包括生成、脑暴、对话、问答、改写、摘要、分类、提取、代码处理以及安全回复等10个大类,共计170个细分测试项。

以MiLM2-1.3B模型和MiLM2-6B模型为例,对比去年发布的一代模型,在十大能力上的效果均有大幅提升,平均提升幅度超过45%。

在生成、闲聊、翻译等关键能力上,MiLM2-6B模型的评测成绩十分优异,对比业内同参数规模模型也有较优的效果。

多个模型尺寸,覆盖云边端

大模型的更新,除了性能的提升,也是打磨模型矩阵的动态过程。

在坚持轻量化部署的大原则下,小米团队将大模型的参数规模灵活扩展至0.3B、0.7B、1.3B、2.4B、4B、6B、13B、30B等多个量级,以适应不同场景下的需求。

0.3B~6B:终端(on-device)场景,应用时通常是一项非常具体的、低成本的任务,提供不同参数规模的模型以适配不同芯片及存储空间的终端设备,微调后可以达到百亿参数内开源模型效果。

6B、13B:在任务明确、且需要比6B以下参数模型提供更多的零样本zero-shot/上下文学习时,6B和13B是一个可能有LLM涌现能力的起点,支持多任务微调,微调后可以达到几百亿开源模型的效果。

30B:云端场景,具备相当坚实的zero-shot/上下文学习或一些泛化能力,模型推理能力较好,能够完成复杂的多任务,基本达到通用大模型水平。

小米自研大模型矩阵不仅包含多样的参数量级,同时也纳入了各种不同的模型结构。

在二代模型系列中,大模型团队特别加入了两个MoE(Mixture of Experts,即混合专家模型)结构的模型——MiLM2-0.7B×8和MiLM2-2B×8。

两个模型的差异主要体现在训练总参数量、词表大小等方面。

MoE模型的工作原理是将多个承担特定功能的“专家”模型进行并行处理,进而综合各模型的输出来提高整体预测的准确度和效率。

以MiLM2-2B×8为例,根据评测结果,该模型在整体性能上与MiLM2-6B不相上下、表现出色,而解码速度实现了50%的提升,在保证模型性能不打折扣的同时,提升了其运行效率。

4B+30B,云端协同运行

特别地,对于端侧,小米第二代大模型的部署技术也有了新的突破,新的4B模型将在端侧发挥更重要的作用。

小米大模型团队创新性地提出了“TransAct大模型结构化剪枝方法”,仅用8%的训练计算量即从6B模型剪枝了4B模型,训练效率大大提升;

同时小米大模型团队自研了“基于权重转移的端侧量化方法”和“基于Outliers分离的端侧量化方法”,大幅降低了端侧量化的精度损失,对比业界标准高通方案,量化损失下降78%。

MiLM2-4B模型总共40层,实际总参数量为3.5B,目前已经实现在端侧部署落地。

同时,在云端运行的MiLM2-30B模型是小米二代大模型系列中参数量级最大的模型。

在云端环境中,大模型面临着多样化和高难度的挑战,需要更高效地遵从并执行用户的复杂指令,深入分析多维度任务,并在长上下文中精准定位信息。

针对这些重点目标,大模型团队选择了一系列开源的评测集,对MiLM2-30B模型的专项能力进行评估。

结果表明,MiLM2-30B模型在指令遵循、常识推理和阅读理解能力方面均有超越主流竞品的出色表现,具体的评测集和评测结果如下:

△指令遵循及常规能力测试结果

△长文本能力测试结果

本文来源:量子位

HUAWEI 华为 Pura 70 Pro 手机 12GB+512GB 雪域白

HUAWEI 华为 Pura 70 Pro 手机 12GB+512GB 雪域白

IDMIX 大麦创新 PD20W 充电宝自带线插头 10000mAh

IDMIX 大麦创新 PD20W 充电宝自带线插头 10000mAh

Akko 艾酷 MOD007 V3机械键盘客制化套件PCBA单键开槽Gasket结构铝合金

Akko 艾酷 MOD007 V3机械键盘客制化套件PCBA单键开槽Gasket结构铝合金

MiniLED180HZ180HZ27

¥1899

¥2399

MiniLED180HZ180HZ27

¥1899

¥2399

SHOKZ 韶音 OpenRun Pro 骨传导蓝牙耳机

SHOKZ 韶音 OpenRun Pro 骨传导蓝牙耳机

FILCO 斐尔可 双模圣手三代 双模机械键盘 104键 红轴

FILCO 斐尔可 双模圣手三代 双模机械键盘 104键 红轴

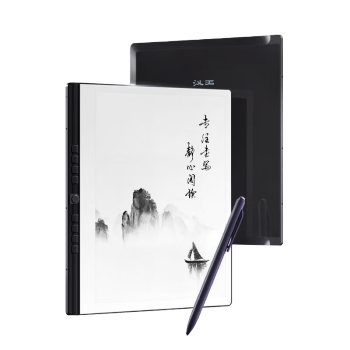

Hanvon 汉王 N10plus 10.3英寸墨水屏电子书阅读器 2GB+32GB

Hanvon 汉王 N10plus 10.3英寸墨水屏电子书阅读器 2GB+32GB

靓点拍(Selfieshow)智能跟拍神器360度旋转云台人脸识别抖音快手网红直播设备自动手势跟踪 【科技黑】人脸识别丨手势控制丨360°旋转

靓点拍(Selfieshow)智能跟拍神器360度旋转云台人脸识别抖音快手网红直播设备自动手势跟踪 【科技黑】人脸识别丨手势控制丨360°旋转

HUAWEI 华为 CD20悦享无线鼠标

HUAWEI 华为 CD20悦享无线鼠标

网友评论