正在举办的英伟达GPU技术大会(GTC)上,英伟达CEO黄仁勋宣布推出新一代GPU ——名为Blackwell的B200 GPU,以及由两片B200与一颗Grace CPU组合而成的第一款Blackwell芯片名为GB200.将于今年晚些时候上市。从ChatGPT开启的人工智能热潮以来,英伟达正在用更强大的芯片来吸引客户,以刺激新订单。

黄仁勋在之前的技术开发者大会上表示:“Hopper很棒,但我们需要更强大的GPU。”

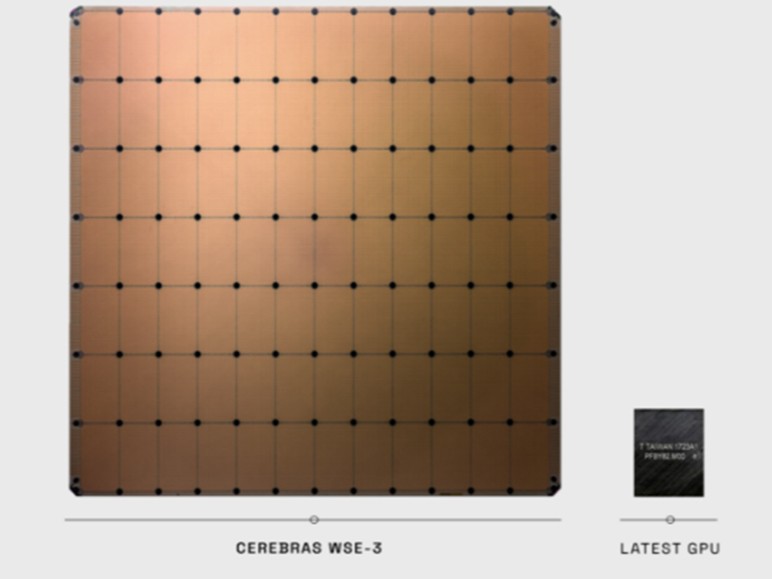

Blackwell拥有2080亿个晶体管,采用台积电4nm制程。前一代GPU“Hopper”H100采用4nm工艺,集成晶体管800亿。英伟达表示,基于Blackwell的处理器,如GB200,为人工智能公司提供了巨大的性能升级空间,其AI性能为20 PetaFLOPS的 FP4 算力,而H100为4 PetaFLOPS。该系统可以部署一个27万亿参数的模型。据称GPT-4使用了约1.76万亿个参数来训练系统。

Blackwell GB200的出现对英伟达来说应是一个新的利好,这些新的性能参数的亮相相信会对大模型芯片市场其他参与者构建更为复杂的挑战,来自推理芯片设计公司Groq和高端CPU供应商(如Cerebras)的竞争,以及老牌厂商AMD和英特尔。

目前来看,英伟达的高端服务器GPU仍是训练和部署大型人工智能模型至关重要的基础设施。此前微软和Meta等公司已经花费了数十亿美元购买这些芯片。

英伟达介绍,该芯片使用了专门用于运行基于大模型人工智能的“大模型引擎”,而这这是ChatGPT的核心技术之一。Blackwell GPU很大,将两个单独制造的小芯片集成到一个由台积电制造的大芯片中。它还将应用到一个名为GB200 NVLink 2的完整服务器中提供,该服务器结合了72个Blackwell GPU和其它Nvidia用于训练人工智能模型的部件。

AWS、谷歌、微软和甲骨文将通过云服务出售GB200的访问权限。英伟达表示,AWS将构建一个包含2万个GB200芯片的服务器集群。

对此,天风国际分析师郭明錤发文表示,此前GH200的出货低于预期,全球主要客户仅Amazon采用。故英伟达对GB200会寄与厚望,并刻意扩大GB200与B100/200的规格差距 (主要是NVlink相关与网路速度),以期透过方案区隔与差异化,提高客户采购GB200的意愿。

英伟达还宣布,它将在其英伟达企业软件订阅中添加一款名为NIM的新产品,NIM代表英伟达推理微服务。NIM可以更容易地使用旧的英伟达GPU进行推理,或者运行人工智能软件的过程,并允许公司继续使用他们已经拥有的数亿个英伟达GPU。与新人工智能模型的初始训练相比,推理需要更少的计算能力。NIM允许那些想要运行自己的人工智能模型的公司,而不是从OpenAI等公司购买人工智能结果的服务。

英伟达将与微软或Hugging Face等人工智能公司合作,确保它们的人工智能模型能够在所有兼容的英伟达芯片上运行。然后,使用NIM,开发人员可以在他们自己的服务器或基于云的Nvidia服务器上有效地运行模型,而无需冗长的配置过程。

Apple 苹果 iPhone 15 Plus 5G手机 512GB 黄色

Apple 苹果 iPhone 15 Plus 5G手机 512GB 黄色

Crucial 英睿达 P3 CT4000P3SSD8 高速版 NVMe M.2 固态硬盘 4TB(PCI-E3.0)

Crucial 英睿达 P3 CT4000P3SSD8 高速版 NVMe M.2 固态硬盘 4TB(PCI-E3.0)

Redmi 红米 12C 4G智能手机 4GB+64GB

Redmi 红米 12C 4G智能手机 4GB+64GB

天钡 T-box 迷你台式机 银色(N100、核芯显卡、8GB、256GB SSD)

天钡 T-box 迷你台式机 银色(N100、核芯显卡、8GB、256GB SSD)

Microsoft 微软 Surface Pro 9 二合一平板电脑

Microsoft 微软 Surface Pro 9 二合一平板电脑

wiiyii 车载HUD抬头显示器

wiiyii 车载HUD抬头显示器

China unicom 中国联通 惠云卡 29元月租(143G全国通用流量+200分钟国内通话)

China unicom 中国联通 惠云卡 29元月租(143G全国通用流量+200分钟国内通话)

HONOR 荣耀 Magic5 5G手机 12GB+256GB 珊瑚紫

¥3799

¥3999

HONOR 荣耀 Magic5 5G手机 12GB+256GB 珊瑚紫

¥3799

¥3999

AOC 冠捷 一体机电脑 2023款 (i5-1035G4,8GB、512GB SSD)

AOC 冠捷 一体机电脑 2023款 (i5-1035G4,8GB、512GB SSD)

网友评论