本文编者为VMware中国资深架构师安浦,基于2024年2月21日VMware by Broadcom 在 Tech Field Day 活动现场AI Field Day 4主题的系列演讲整理。演讲嘉宾为Chris Wolf,Senior Director of Engineering, AI and Advanced Services,VMware By Broadcom。

内容摘要

-VMware与众多AI领域ISV厂商有着很好的合作基础,彼此之间是非竞争性关系,VMware专注于提供AI基础设施、优化、安全、数据隐私和数据服务。

-VMware从自己的AI实践中获益颇多,在有限的预算内实现了更高效的价值。

-VMware Private AI解决方案的优势:

**为企业AI基础设施的构建提供更多灵活性和选择性;

**Private AI解决方案增强了隐私保护和安全控制能力;

**实现快速创建AI工作集群并加载预装模型,极大简化部署流程,提高工作效率;

**更加智能地管理AI算力资源,实现不同应用场景之间的GPU算力分配,从而提高资源利用率;

**避免产生新的AI算力池运维孤岛,实现与现有运营工具集成,降低总体拥有成本;

**在用户既有的VMware环境中直接应用AI模型, 实现既有数据湖与新的AI模型连接的能力;

**VMware Private AI Foundation,通过与业界领先AI厂商的产品集成,以及推广开源参考架构,加速将AI计算和模型引入企业数据中心、公有云和边缘设备的进程。

-VMware携手客户和ISV生态伙伴共同打造Private AI开放生态环境。

VMware与众多AI领域ISV厂商有着很好的合作基础

VMware在2023年8月推出了Private AI,其目标是加速实现AI的普惠化,并激发各行业的业务创新能力。在这一过程中,我们认识到隐私和控制对于许多组织至关重要,这也是VMware希望集中关注并提供支持的领域。

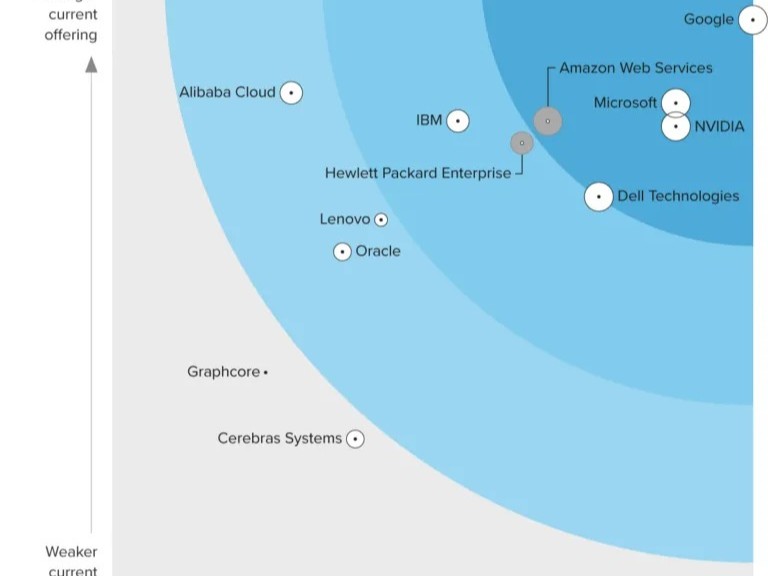

我们注意到,当前许多AI独立软件供应商(ISV)非常愿意与VMware合作,因为在AI基础设施、优化、安全、数据隐私和服务方面,VMware并不与他们产生直接竞争关系。VMware明确表示,顶层的AI服务是这些ISV的专业领域,而VMware则专注在为AI基础设施层面提供平台技术支持。与之相反,在公有云领域中,公有云服务商经常也提供顶层AI服务,不可避免的构成与ISV的直接竞争关系。对于AI生态环境的众多ISV厂商而言,选择与VMware合作共同进入客户的项目,需要彼此之间建立充分的信任关系,VMware清晰的定位有助于解决这一问题。

VMware自身也是AI技术发展的受益者

在AI实际应用方面,当前许多组织的研发团队都在研究代码辅助生成这一领域,VMware也在该领域进行了探索。比如,我们针对C开发的ESXi内核进行了尝试,选择了一个极具挑战性的使用场景,希望我们的软件工程师能够从中受益。当我们开始采用这个基于开源模型打造的内部辅助代码生成解决方案时,软件工程师的接受率高达92%。这让我们备受鼓舞,证明了我们可以在有限的预算内实现更高效的价值。

我们也进行了一项试点项目,并正在进行额外的测量工作。我们关注的是能够严格控制的AI代码开发领域。对于VMware而言,一个优势是我们内部本就会进行复杂的代码扫描,以确保开源合规性。我们在这方面投入了大量精力,确保对使用的任何开源代码都有适当的合规引用。正式藉由这些内部流程,我们得以取得成功。目前,我们仍在进一步努力,以确定如何为AI生成的代码提供适当的合规引用,并努力推动这一领域的发展。

和许多企业一样,VMware也具有探索精神。我们持续关注着GitHub Copilot的发展。然而,我们最初的使用案例主要集中在上游开源,因为这不会对我们的知识产权或其它方面产生任何影响。VMware设有AI委员会,并制定了相应的治理实践。在这个领域,我们认为自己领先于许多尚未建立此类治理机制的公司。这是一个持续努力的过程,但无疑我们已取得了显著的进展。

至于呼叫中心的解决方案,每个组织都有这方面的需求,无论是高级信息检索还是处理医疗保健、法律、销售或客户支持等领域的数据。能够快速为技术支持人员提供答案,都是具有实际的商业价值的。我们的解决方案可以为你提供帮助,并且在数据收集方面,也为用户提供许多开源解决方案以供选择。例如,围绕LlamaIndex的开源社区提供了许多数据采集器,这些解决方案通常可以在几周内甚至更早地被启用。这些早期使用案例为我们展示了其强大的潜力。

VMware Private AI解决方案的优势

从VMware Private AI解决方案的特定优势来看,我们追求的是确保隐私和安全性下的灵活性和选择性。无论选择运行解决方案的硬件还是软件,我们都希望组织能够进行有效的AI基础设施投资,并享有更多的选择权。商业AI服务、云AI服务或开源AI服务,不同的业务线可能有不同的优先事项或偏好。因此,投资可以支持上述所有类型AI服务的基础设施,对于实现性能优化、简化部署以及降低风险至关重要。

在部署方面,我们正在做一些其它公司尚未涉足的事情。这也涉及到实施方式和性能。通过我们的方案,用户可以在大约3秒钟内启动一个AI集群,并将您的模型预加载到内存中。这在公有云或裸机上都是无法实现的。我们从行业合作伙伴那里了解到,在裸机上完成这一操作通常需要5到7分钟。

用户关注如何最有效的管理其IT环境中的AI算力资源。当需要同时管理多个项目,而每个项目都要使用一个独立的集群或云服务时,是无法做到这一点,而且这些资源的实际利用率会出现高峰与低谷。

客户选择VMware的主要原因有如下几个:

首先,我们拥有被市场广泛认可的虚拟化基础设施层,这意味着客户可以更加智能地管理内存访问、GPU访问以及网络容量需求,并在这些不同的应用场景之间实现资源的智能分配。正如之前提到的,对于推理应用场景,可能只需要部分GPU资源,而VMware在这方面的技术非常成熟,例如DRS,它可以根据不同工作负载的容量需求进行负载均衡。

其次,从管理操作的角度来看,客户不希望为AI工作负载建立独立的运维孤岛,因为这涉及大量的资金投入、新工具、新流程等。通过VMware解决方案,客户可以利用现有的工具集和长期执行的流程,从而避免投资于全新的工具孤岛环境。

这两点因素使得我们的客户期望通过我们的解决方案技术栈实现更低的总体拥有成本。

第三点是选择权。我们专注于这些领域,并希望与合作伙伴在这些领域建立合作关系。这同样令客户感到兴奋,因为他们不希望被迫接受单一的AI技术堆栈,而是希望保留自己的数据和选择的存储方式,同时能够引入新的AI应用服务。

在某种程度上,VMWare正在拓展自己的业务领域,不再仅限于技术提供商的角色,而是正努力成为客户的解决方案提供商,但并不仅仅如此。我们也在继续支持行业解决方案提供商,积极推广开源技术。我们正在为所有的合作伙伴创建Private AI参考架构和指南,并提供我们的应用供他们使用,甚至正在考虑将其开源。系统集成商可以根据需要自定义和支持这些应用,并为其客户提供有偿服务。我们在能够增加价值的地方投入资源,分享我们在行业中的最佳实践,以便其它人也能从中受益。

VMware在AI应用场景方面的另外一个重要优势,就是许多客户希望将AI引入他们已有的数据环境中,很多组织在大力推广AI或LLM之前,已经成功建立并使用了数据湖/仓、商业智能模型等,而这个环境往往是基于VMware底座的。因此,他们希望能够在现有的VMware环境中直接应用AI模型, 而VMware拥有将这些现有数据湖/仓与新的AI模型连接的能力。

以我之前分享的零售案例为例,他们不希望将所有店铺的数据传输到中央数据湖中进行推理,而是希望能在本地进行快速响应。每家店铺的AI处理仅需两个GPU。这是一个真实运行的AI场景,处理24到36个走廊上的摄像头数据。虽然我不能透露具体的走廊数量,但这样的应用场景正在不断增加,对VMware来说具有巨大的价值。客户希望我们能够参与这些项目并提供支持。

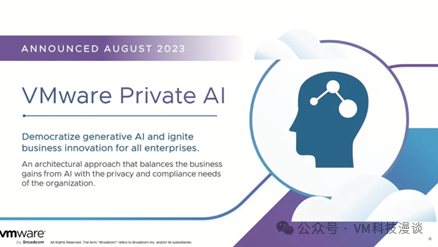

在解释为何选择VMware时,我还想补充一点,我们已拥有众多安全功能,包括安全启动和虚拟TPM等,这些功能在保护模型和数据机密性方面至关重要。与第三方身份管理的集成可以使用微分段隔离和分布式防火墙等技术来隔离你的AI模型和服务,这对于不断发展的组织来说至关重要。

Private AI解决方案下的AI性能表现优异

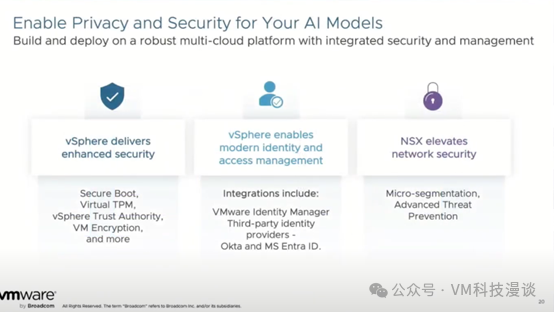

我想简要提及一下我们即将进行的另一场演讲,届时我们将深入探讨有关性能的问题。

此次展示仅针对某一语言模型的推理基准,与裸金属相比,在最差情况下,我们仍保持在小于1%左右的水平。而在另一场演讲中,我们将展示另一个基准,显示我们相比裸金属的性能高出5%或6%,这全赖我们的调度算法以及我们在这一领域所做的努力。

在虚拟化的环境中,可以获得所有AI计算的优势,即便是对GPU进行虚拟化和切片,也不会牺牲性能。除非真的在意那1%。如果是这样,裸金属应用场景当然是一个不二选择。但如果不是,就可以从虚拟化的AI算力底座中获得巨大的收益。

另外,我们在模型训练方面也有一些基准测试,通常,大型LLM训练会在裸金属或公有云上进行,这并非我们的重点。我们的关注点在于微调模型。因此,微调场景和推理场景是你从GPU虚拟化和切片中真正获得最大好处的地方。若需数十到数百个GPU来训练大型模型,这暂时可能还不是虚拟化的适用场景,但未来可能会有所变化。当你已拥有足够的GPU算力容量,并希望将其用于其它用途时,为何不充分利用呢?

与友商合作,基于VCF构建完整Private AI解决方案

VMware提供了一套参考架构供客户选择,如果他们希望采取更自助的服务模式,我们也为他们提供了详尽的指引。然而,我们的长远目标是希望客户能够先构建一个高效的基础架构,基于VMware Cloud Foundation,然后在此基础上部署Private AI,包括GPU和AI服务。建议客户先简化并优化算力基础设施环境,这样就能更好地获得最终的成本效益。

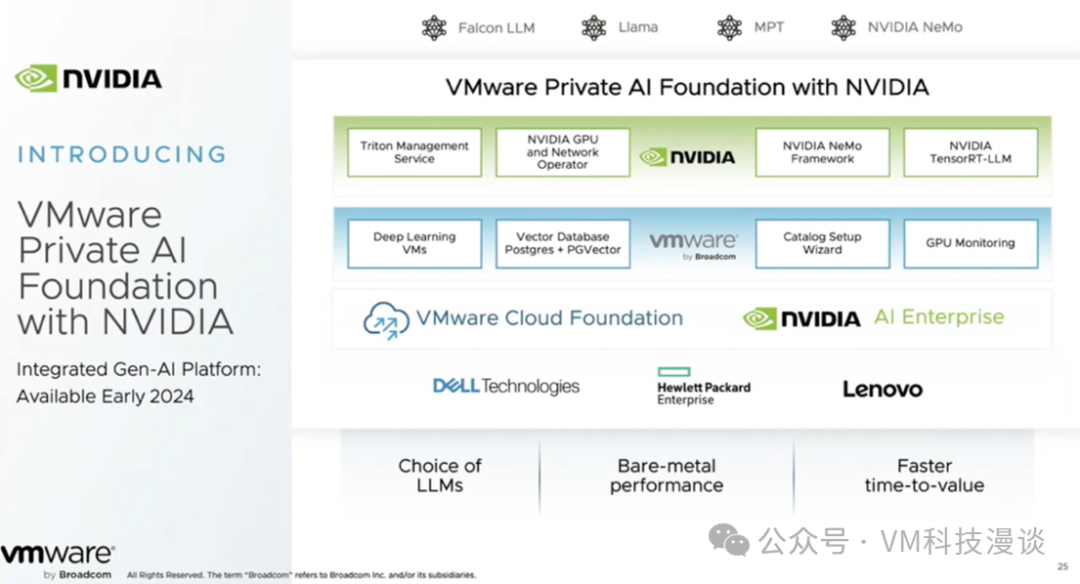

客户可以根据自己的需求使用VCF。VMware将推出一个Private AI Foundation,与NVIDIA合作提供附加组件,包括集成的向量数据库支持等额外功能。客户可以从VCF开始,购买附加组件以获得这些功能。对于需要向量数据库的客户,这将是一个额外的优势。我们将所有这些功能整合在一起,提供完整的NVIDIA软件堆栈,确保所有功能都能无缝集成。

VMware携手客户及ISV生态伙伴共同打造Private AI开放生态环境

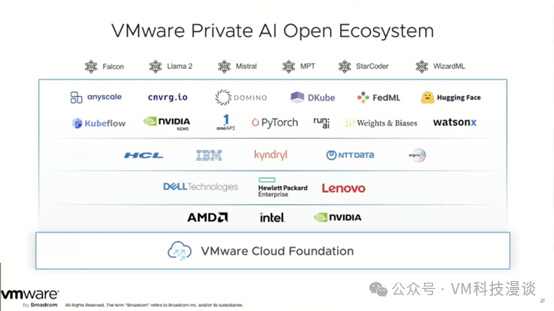

深入思考我们所精心打造的生态系统,其重要性不言而喻。正如之前提到的,我们专注于AI基础设施及其上运行的服务。我们的Tanzu团队与客户紧密合作,提供定制服务。同时,我们也非常重视合作伙伴群体,今年将有更多合作伙伴加入,共同创造更多的价值。这些合作伙伴不仅限于传统ISV,还包括那些在云中运行并意识到大量本地应用场景的企业。他们希望把握这些机会,而与VMware合作是实现这一目标的最佳选择,因为我们始终与客户业务保持紧密联系。

VMware AI解决方案相关信息链接

Artificial Intelligence Solutions | VMware AI: https://www.vmware.com/artificial-intelligence.html

VMware's Approach to Private AI: https://news.vmware.com/technologies/vmware-technology-private-ai

Deploying Enterprise-Ready Generative AI on VMware Private AI: https://core.vmware.com/resource/deploying-enterprise-ready-generative-ai-vmware-vmware-cloud-foundation

GDSHARK 六维鲨 S13U6 13.3英寸便携式IPS显示器(3840*2160、60Hz、100%AdobeRGB)

GDSHARK 六维鲨 S13U6 13.3英寸便携式IPS显示器(3840*2160、60Hz、100%AdobeRGB)

Lexar 雷克沙 专业版 Type-C 3合1读卡器

Lexar 雷克沙 专业版 Type-C 3合1读卡器

VXE R1SE 2.4G蓝牙 多模无线鼠标 18000DPI

VXE R1SE 2.4G蓝牙 多模无线鼠标 18000DPI

FUJIFILM 富士 instax Pal一次成像拍立得 官方标配 赠 PAL羽绒围巾+挂件

FUJIFILM 富士 instax Pal一次成像拍立得 官方标配 赠 PAL羽绒围巾+挂件

BEITONG 北通 斯巴达3 多模无线游戏手柄

BEITONG 北通 斯巴达3 多模无线游戏手柄

AMD R5 5600G CPU散片 6核12线程

AMD R5 5600G CPU散片 6核12线程

CHINA TELECOM 中国电信 长期静卡 29元月租(125G通用流量+30G定向流量)

CHINA TELECOM 中国电信 长期静卡 29元月租(125G通用流量+30G定向流量)

Lenovo 联想 SL7000 NVMe M.2 固态硬盘 512GB(PCI-E 4.0)

Lenovo 联想 SL7000 NVMe M.2 固态硬盘 512GB(PCI-E 4.0)

云腾691单反三脚架 微单相机液压阻尼云台手机稳定户外便携式铝合金支架艺考直播拍照拍摄摄影vlog视频三角架

云腾691单反三脚架 微单相机液压阻尼云台手机稳定户外便携式铝合金支架艺考直播拍照拍摄摄影vlog视频三角架

网友评论